Open-Source-Sprachmodelle sind derzeit extrem spannend – und das aus gutem Grund. Llama 3, Mistral, Mixtral, DeepSeek, Gemma ... jede Woche bringt die Community neue Modelle, die schneller, günstiger und leistungsfähiger sind.

Aber sobald Sie versuchen, diese Modelle in eine reale Unternehmensumgebung zu integrieren – mit abteilungsübergreifenden Nutzergruppen, sensiblen Daten und strengen Compliance-Anforderungen – stoßen Sie schnell an eine Grenze. Eine frustrierende, architektonische Mauer. Eine, die kein Benchmark der Welt überwindet.

Sie können das Modell hosten. Sie können das Modell ausführen.

Aber können Sie es betreiben – sicher, konsistent und mandantenfähig – ohne eine eigene AI-Plattform von Grund auf aufzubauen?

Genau diese Lücke schließen wir mit Scalytics Connect.

Der Traum und die Realität selbstgehosteter LLMs

Jeder liebt die Idee, Modelle wie Llama 3 lokal auszuführen: volle Kontrolle, keine API-Kosten, keine Herstellerbindung. Doch in der Praxis dauert es meist nur wenige Tage, bis die ersten Reibungspunkte auftauchen:

- Sie können nicht mehr als einen aktiven Nutzer bedienen, ohne auf Race Conditions oder verlorene Kontexte zu stoßen.

- Sie können keine System-Prompts erzwingen, um das Modellverhalten zuverlässig einzuschränken.

- Sie haben keine Kontrolle über Eingabelängen, Antwortgrößen oder über die effiziente Zusammenfassung langer Gesprächsverläufe.

- Sie können nicht nachverfolgen, welcher Nutzer was getan hat – oder wie ein Modell zu seiner Antwort gekommen ist.

- Und Sie können nicht verhindern, dass versehentlich sensible Kundendaten an ein Modell gehen, das dafür nicht autorisiert ist.

Das liegt daran, dass heutige Tools – Ollama, LM Studio, lokale vLLM-Setups – für Einzelentwickler gebaut wurden, nicht für Unternehmensinfrastrukturen.

Sie liefern Ihnen die Modellausführung.

Wir liefern den operativen Unterbau.

Also, warum Scalytics Connect?

Scalytics Connect ist eine speziell entwickelte Runtime für den sicheren Betrieb von Open-Source-LLMs in echten Unternehmensumgebungen – mit mehreren Benutzern, Gruppenrechten, klaren Richtlinien und hohen Datenschutzanforderungen.

Es liefert genau die Bausteine, die klassischen LLM-Hosting-Tools fehlen:

- Sitzungsorientiertes Queuing und isolierte Verarbeitung von Anfragen

- Zentrale System-Prompt-Durchsetzung in Echtzeit

- Intelligente Verwaltung von Kontextfenstern und Token-Budgets

- Globale Datenschutz- und Zugriffskontrollen

- Vollständige Audit-Trails für jede Inferenz

- API- und Dashboard-Steuerung, wie sie Unternehmen erwarten

Scalytics Connect ist die Runtime-Schicht, die Sie brauchen, wenn "nur das Modell ausführen" nicht mehr ausreicht.

Wir bauen keinen Spielplatz.

Wir bauen die Steuerungsebene für sichere, erklärbare und datenschutzkonforme LLMs – einsatzbereit für die Produktion.

Lassen Sie uns die wichtigsten Architekturentscheidungen anschauen, die dieses System möglich gemacht haben.

1. Statuslose Sprachmodelle, blockierende Inferenz – das Problem bei parallelen Nutzern

Offene Modelle wie Llama oder Mistral sind von Natur aus zustandslos. Das macht sie extrem leistungsfähig für Inferenzaufgaben – aber gleichzeitig ungeeignet für den parallelen Einsatz durch mehrere Nutzer.

Warum? Ganz einfach:

- Die Inferenz blockiert: Solange das Modell generiert, ist es vollständig ausgelastet.

- Kein eingebautes Gedächtnis: Jeder Prompt muss bei jedem Request den kompletten Kontext mitbringen – inklusive Verlauf, System-Prompts und Instruktionen.

- Keine integrierte Warteschlange: Wenn mehrere Benutzer gleichzeitig Anfragen stellen, warten sie... oder geraten miteinander in Konflikt.

Das mag für einen persönlichen Assistenten auf localhost noch vertretbar sein.

Aber sobald Sie Dutzende oder Hunderte von gleichzeitigen Nutzeranfragen zuverlässig und datenschutzkonform verarbeiten wollen, wird es zum echten Problem.

Scalytics Connect schließt genau diese Lücke – mit einer integrierten Warteschlangen- und Routing-Schicht, die klassische Inferenz-Stacks schlicht nicht bieten.

Unser System verwaltet sitzungsbasierte Queues, weist Jobs gezielt verfügbaren Modell-Workern zu und isoliert jede Anfrage pro Benutzer und Kontext.

Was das für Sie bedeutet:

- Parallele Chats gegen dasselbe Modell – kein Problem

- Kontrollierte Speichernutzung und tokenbasierte Limits pro Sitzung

- Keine GPU-Blockaden, keine verlorenen Antworten, kein Chaos

Und das Beste: All das läuft hinter den Kulissen.

Keine spezielle Client-Logik. Keine ad-hoc-Konfigurationen. Nur sauberes, sicheres Inferenzmanagement.

2. Der Auri System Prompt: Wie wir unternehmensweites Modellverhalten zuverlässig durchsetzen

Die meisten halten System-Prompts für optional. Bei Scalytics sind sie ein zentrales Sicherheits- und Steuerungselement.

Wir setzen konsequent durch, was wir die Scala Prompt nennen – eine standardisierte, unternehmensweit gültige Verhaltensrichtlinie, der jedes Modell in regulierten Umgebungen folgen muss.

Diese enthält unter anderem folgende Regeln:

- Antworten nur auf Basis des bereitgestellten Kontexts

- Keine erfundenen Fakten oder Einbindung externen Wissens

- Keine Beratung in eingeschränkten Bereichen wie Finanzen, Medizin oder Recht

- Keine Speicherung, Wiederverwendung oder Offenlegung sensibler Nutzereingaben

Man kann es sich vorstellen wie eine Kombination aus Inhaltsmoderation, Datenschutz und Verhaltensleitplanken – direkt auf Modellebene.

In Scalytics Connect ist dieses Verhalten pro Modell konfigurierbar. Ist die Option aktiviert:

- Hängen wir die Scala Prompt automatisch an die benutzerdefinierte System-Prompt des Users an – so bleibt die Nutzerabsicht erhalten, aber die Compliance-Vorgaben werden dennoch erzwungen.

- Protokollieren wir die vollständige effektive Prompt-Kette (User + Scala Prompt) für vollständige Nachvollziehbarkeit.

- Blockieren wir unsicheres Verhalten direkt zur Inferenzzeit – nicht erst durch nachgelagerte Filtermechanismen.

Das ist kein „Prompt Engineering“.

Das ist runtime-basierte Richtlinien-Durchsetzung, wie sie in Unternehmen notwendig ist.

3. Das Problem mit dem Kontextfenster – und warum wir einen tokenbewussten Inference Router entwickeln mussten

LLMs haben kein Gedächtnis. Sie haben ein Token-Limit.

Jedes Modell – Llama 3 (8k), Mixtral (32k), GPT-4 (128k) – hat eine festgelegte maximale Anzahl an Tokens, die es pro Anfrage verarbeiten kann. Dieses Limit umfasst:

- die System-Prompt

- den bisherigen Gesprächsverlauf

- die aktuelle Benutzereingabe

- sowie den Platz für die Antwort des Modells

Wird dieses Limit überschritten, erhalten Sie entweder einen Fehler, eine kryptische Kürzung oder schlicht eine unvollständige, qualitativ schlechte Antwort.

Scalytics Connect löst dieses Problem mit einem tokenbewussten Inference Router.

Bevor eine Anfrage überhaupt beim Modell landet, durchläuft sie mehrere Absicherungsstufen:

- Prüfen der Gesamtlänge der Anfrage (Systemprompt + Verlauf + aktuelle Nachricht)

- Optionales Zusammenfassen älterer Gesprächsabschnitte, wenn eine definierte Warnschwelle überschritten wird

- Selektives Kürzen der ältesten Elemente, wenn keine Zusammenfassung aktiviert ist oder diese nicht ausreicht

- Finale Validierung der Tokenanzahl – vor der Modellinferenz, nicht danach

- Verwerfen und Protokollieren der Anfrage, wenn selbst die optimierte Eingabe das Tokenlimit überschreitet

Diese tokenbewusste Steuerung sorgt dafür, dass große Sprachmodelle stabil, nachvollziehbar und qualitativ hochwertig eingesetzt werden können – ohne stille Fehler, abgeschnittene Antworten oder Systeminstabilitäten.

Ein Predictable LLM Stack beginnt mit Kontrolle – nicht mit Trial & Error.

4. Global Privacy Mode: Volle Kontrolle über Datenflüsse und Modellzugriff

Eine der wirkungsvollsten Funktionen von Scalytics Connect ist gleichzeitig eine der simpelsten: der globale Datenschutzmodus.

Mit nur einem Schalter können Administratoren den gesamten Datenfluss kontrollieren – und zwar zuverlässig, systemweit:

- Alle externen Modelle und API-Provider werden deaktiviert

- Alle Inferenzanfragen werden gezwungen, lokal verarbeitet zu werden

- Keine Daten verlassen den vertrauenswürdigen Infrastrukturgrenzbereich

Dieser Modus wird nicht nur oberflächlich aktiviert, sondern tief im System verankert:

- im Modell-Routing

- bei der Auswahl aktiver Anbieter

- innerhalb der Benutzereinstellungen

- und direkt im Frontend-Zugriff

Das bedeutet: Sie verlassen sich nicht auf Nutzerdisziplin, lokale Umgebungsvariablen oder nachträgliche Workarounds.

Die Kontrolle ist in die Runtime selbst eingebaut – robust, durchsetzbar und auditierbar.

5. Ohne Einblick kein Vertrauen: Warum Observability in der LLM-Betriebsschicht unerlässlich ist

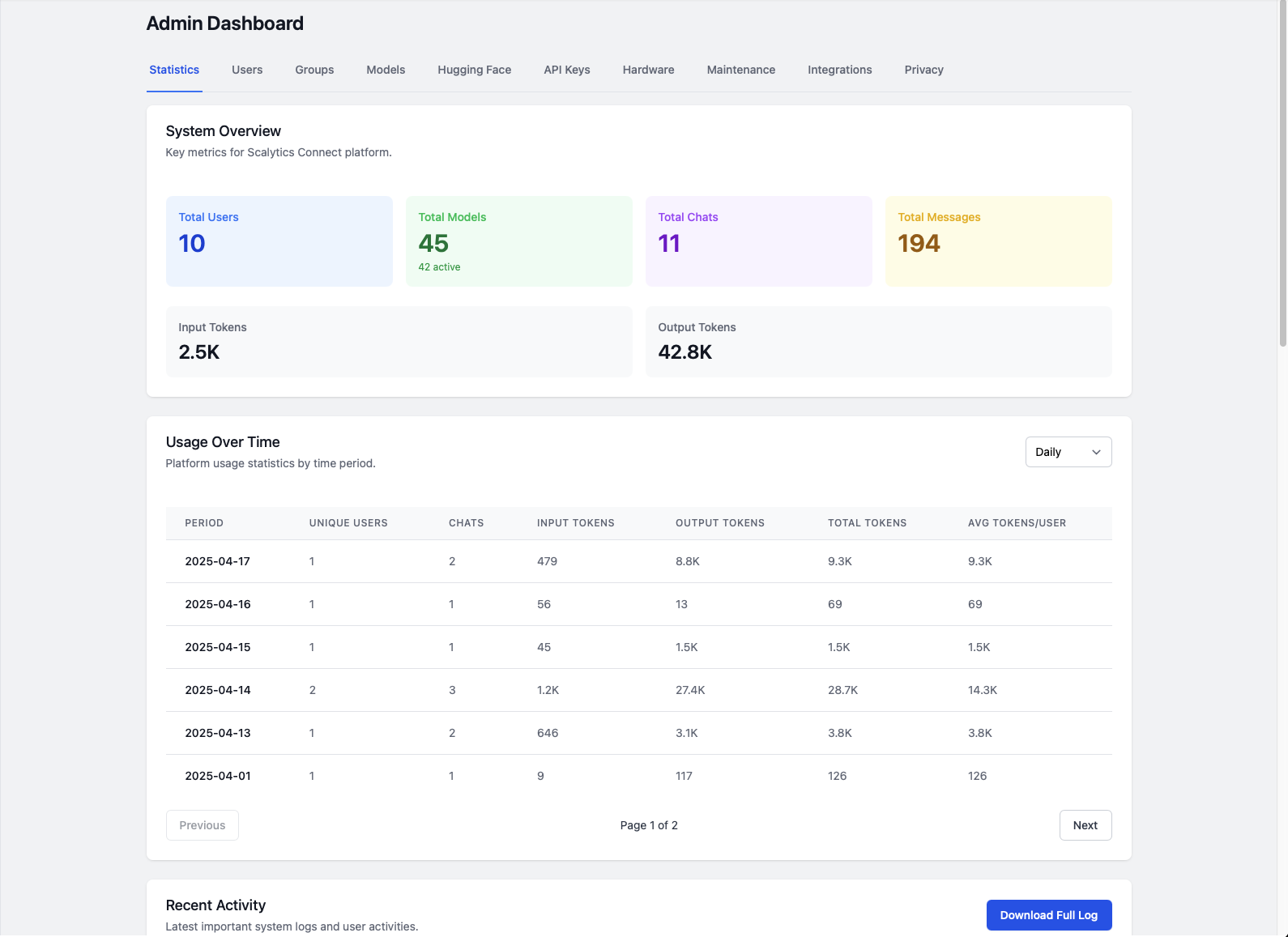

Jeder Bestandteil von Scalytics Connect ist von Grund auf auf Beobachtbarkeit ausgelegt.

Das bedeutet vollständige Transparenz über jede einzelne Inferenz – in Echtzeit und historisch nachvollziehbar. Konkret protokolliert das System:

- Vollständige Anforderungslogs: Wer hat was gefragt, mit welchem Modell und zu welchem Zeitpunkt

- Token-Zählungen: Vor und nach eventueller Zusammenfassung oder Kürzung

- Effektive Prompts: Kombination aus Benutzereingabe, Systemprompt und durchgesetzten Leitplanken

- Anzahl der Ausgabetokens und Generierungszeit

- Warnungen, wenn Token- oder Kontextgrenzen erreicht werden

Diese Logs sind nicht nur für das Debugging hilfreich.

Sie bilden die Grundlage für Compliance, Audit-Readiness und vernetztes Vertrauen – insbesondere in Umgebungen mit mehreren Teams, regulatorischen Anforderungen oder sensiblen Datenströmen.

Was Sie nicht sehen, können Sie nicht sichern.

Und genau deshalb ist vollständige Observability kein Extra – sondern Pflicht.

Die Zukunft von LLMs liegt nicht nur in offenen Modellen, sondern in ihrer Betriebsfähigkeit.

Modelle mit offenen Gewichten sind mächtig.

Aber solange Sie sie nicht sicher, erklärbar und teamübergreifend betreiben können, bleiben sie Experimente.

Scalytics Connect macht genau das möglich – und bringt offene Modelle in den Produktionseinsatz.

Zugegeben: Föderierung ist noch nicht Teil des aktuellen Stands.

Aber der komplexeste Teil ist bereits gelöst – die kontrollierte Ausführung zustandsloser Modelle in Multiuser-Umgebungen mit Datenschutz, Speichermanagement und verbindlichen Laufzeitgarantien.

Ganz gleich, ob Sie:

- einen privaten Assistenten für Ihr Produktteam aufbauen,

- KI-gestützte Workflows im Gesundheitswesen implementieren oder

- sichere, lokale Inferenz im Finanz- oder Verteidigungsumfeld benötigen –

Connect liefert Ihnen die operative Schicht zwischen Modell und Nutzer, die in jedem echten Enterprise-Stack bisher gefehlt hat.

Über Scalytics

Unser Hauptprodukt, Scalytics Connect, bietet intelligente Topics, kontinuierliches Lernen und KI-fähiges Messaging über das Model Context Protocol (MCP). Es verbindet verschiedene Datentypen und stellt sicher, dass Regeln eingehalten werden und die Privatsphäre geschützt wird, ohne dass die Pipelines, die Teams bereits nutzen, geändert werden müssen.

Mit Funktionen wie Autodiscovery und indexbasierter Suche bietet Scalytics Connect ein zukunftsweisendes, transparentes Framework, das schnelle Produktiteration, robuste Skalierung und erklärbare KI unterstützt. Durch die Kombination von Agenten, Datenflüssen und Geschäftsanforderungen hilft Scalytics Unternehmen, traditionelle Beschränkungen zu überwinden und die Möglichkeiten moderner KI voll auszuschöpfen.

Wenn Sie professionelle Unterstützung von unserem Team von branchenführenden Experten benötigen, können Sie sich jederzeit an uns über Slack oder E-Mail wenden.