Föderiertes Lernen ist insofern ein zweischneidiges Schwert, als es darauf ausgelegt ist, den Datenschutz zu gewährleisten, doch leider öffnet es Gegnern die Tür, das System leicht auszunutzen. Einer der beliebtesten Angriffsvektoren ist ein sogenanntes Poisoning, das Vergiften der dezentralen Rohdaten.

Was ist eine Vergiftungsattacke?

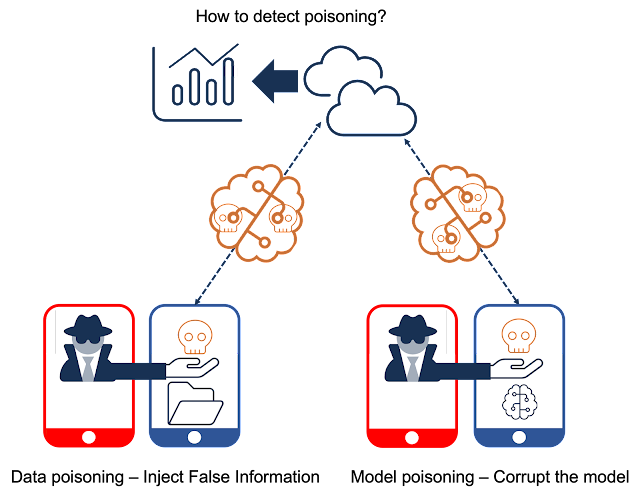

Ein Poisoning-Angriff zielt darauf ab, Modelle für maschinelles Lernen auf einfache Weise zu schwächen. Diese lassen sich in zwei Kategorien einteilen: Daten- und Modellvergiftungsangriffe.

Datenvergiftungsangriffe zielen darauf ab, die Trainingsdaten zu kontaminieren, um indirekt die Leistung von Modellen für maschinelles Lernen zu beeinträchtigen [1]. Datenvergiftungsangriffe lassen sich grob in zwei Kategorien einteilen: (1) Label-Flipping-Angriffe, bei denen ein Angreifer die Bezeichnungen von Trainingsdaten „umdreht“ [2] (2) Backdoor-Angriffe, bei denen ein Angreifer neue oder manipulierte Trainingsdaten injiziert, was zu einer Fehlklassifizierung während der Inferenzzeit führt [3]. Ein Angreifer kann globale oder gezielte Datenvergiftungsangriffe ausführen. Gezielte Angriffe erhöhen die Gefahr, erkannt zu werden, da sie nur eine bestimmte Klasse manipulieren und Daten für andere Klassen intakt machen.

Andererseits zielt ein Modellvergiftungsangriff darauf ab, lokale Modelle direkt zu manipulieren, um die Genauigkeit globaler Modelle zu gefährden. Model-Poisoning-Angriffe können als ungezielte oder gezielte Angriffe ausgeführt werden, ähnlich wie Datenvergiftungsangriffe. Ein ungezielter Angriff zielt darauf ab, die Gesamtleistung zu verschlechtern und einen Denial-of-Service zu erreichen. Ein gezielter Angriff ist eine raffiniertere Methode, um Modellaktualisierungen für Unteraufgaben zu beschädigen und gleichzeitig eine hohe Genauigkeit bei der Erreichung globaler Ziele aufrechtzuerhalten [1].

Ein föderiertes Lernsystem ist von Natur aus anfällig für Giftangriffe, da es nicht auf lokale Daten und Modelle einzelner Teilnehmer zugreifen kann. Gezielte Angriffe verschärfen das Problem, da es für einen zentralen Server extrem schwierig wäre, Angriffe in den Modellen zu identifizieren, wenn man die globalen Ziele mit hoher Genauigkeit berücksichtigt.

Wie können wir uns verteidigen?

Ansätze zur Abwehr von Vergiftungsangriffen lassen sich in zwei Kategorien einteilen: (1) Robuste Aggregation und (2) Anomalieerkennung. Eine typische Aggregationsmethode im föderierten Lernsystem ist der Durchschnitt lokaler Modelle, um ein globales Modell zu erhalten. Beispielsweise berechnet jeder Client in jeder Runde von Trainingsphasen Gradienten, die Gradienten werden an einen zentralen Server gesendet und der Server berechnet die durchschnittlichen Gradienten in FedSGD [4]. Zur besseren Effizienz berechnet jeder Client den Gradienten und aktualisiert das Modell für mehrere Chargen. Die Modellparameter werden an den Server gesendet, und der Server berechnet den Durchschnitt der Modellparameter in FedAVG [5]. Offenbar sind diese auf Durchschnittswerten beruhenden Ansätze anfällig für Poisoning-Angriffe. Der Forschungsschwerpunkt lag daher auf der Frage, wie die Modellparameter besser aggregiert und gleichzeitig minimiert werden können, wie z. B. Medianaggregation [6], Aggregation des getrimmten Mittelwerts [6], Krum-Aggregation [7] oder Algorithmen zur adaptiven Mittelwertbildung [1].

Eine proaktivere Methode zur Abwehr von Poisoning-Angriffen ist das Filtern bösartiger Updates mithilfe der Anomalieerkennung. Modellaktualisierungen bösartiger Clients sind oft von denen seriöser Kunden zu unterscheiden. Eine Abwehrmethode sind Cluster-basierte Ansätze, die Modellaktualisierungen auf dem zentralen Server und Cluster-Modell-Updates überprüfen und verdächtige Cluster aus der Aggregation herausfiltern [8]. Verhaltensbasierte Abwehrmethoden messen Unterschiede bei Modellaktualisierungen zwischen den Clients und filtern bösartige Modellaktualisierungen aus der Aggregation heraus [8].

Fazit

Vor Kurzem ist ein föderiertes Lernsystem entstanden, weshalb sich die Erforschung von Angriffen gegen dieses System noch in einem frühen Stadium befindet. Um die vielversprechenden Potenziale des föderierten Lernsystems voll auszuschöpfen, sind umfangreiche Forschungsanstrengungen erforderlich, um die Robustheit gegen Giftangriffe zu gewährleisten.

Referenzen

- [1] Jere, Malhar S., Tyler Farnan und Farinaz Koushanfar. „Eine Taxonomie von Angriffen auf föderiertes Lernen.“ IEEE Security & Privacy 19, Nr. 2 (2020): 20-28.

- [2] Tolpegin, V., Truex, S., Gursoy, M.E., & Liu, L. (2020, September). Datenvergiftungsangriffe auf föderierte Lernsysteme. Im Europäischen Symposium zur Erforschung der Computersicherheit (S. 480-501). Springer, Cham.

- [3] Severi G, Meyer J, Coull S, Oprea A. {Explanation-Guided} Backdoor-Poisoning-Angriffe gegen Malware-Klassifikatoren. Auf dem 30. USENIX-Sicherheitssymposium (USENIX Security 21) 2021 (S. 1487-1504)

- [4] Mhaisen, Naram, Alaa Awad Abdellatif, Amr Mohamed, Aiman Erbad und Mohsen Guizani. „Optimale Zuweisung von Benutzerkanten beim hierarchischen Verbundlernen auf der Grundlage statistischer Eigenschaften und Einschränkungen der Netzwerktopologie.“ IEEE-Transaktionen zu Netzwerkwissenschaft und Netzwerktechnik 9, Nr. 1 (2021): 55-66

- [5] Zhou, Yuhao, Qing Ye und Jiancheng Lv. „Kommunikationseffizientes Verbundlernen mit kompensiertem Überlappungsaufwand.“ IEEE-Transaktionen auf parallelen und verteilten Systemen 33, Nr. 1 (2021): 192-205

- [6] Yin, D., Chen, Y., Kannan, R., & Bartlett, P. (2018, Juli). Byzantinisches robustes verteiltes Lernen: Auf dem Weg zu optimalen statistischen Raten. In der Internationalen Konferenz über maschinelles Lernen (S. 5650-5659). PMLR.

- [7] Blanchard, Peva, El Mahdi El Mhamdi, Rachid Guerraoui und Julien Stainer. „Maschinelles Lernen mit Gegnern: Byzantinischer toleranter Gradientenabstieg.“ Fortschritte in neuronalen Informationsverarbeitungssystemen 30 (2017)

- [8] Awan, Sana, Bo Luo und Fengjun Li. „Contra: Verteidigung gegen vergiftete Angriffe beim föderierten Lernen.“ Im Europäischen Symposium zur Erforschung der Computersicherheit, S. 455-475. Springer, Cham, 2021

- [9] Fang, Minghong, Xiaoyu Cao, Jinyuan Jia und Neil Gong. „Lokale Modelle vergiften Angriffe auf {byzantinisch-robustes} föderiertes Lernen.“ Im 29. USENIX-Sicherheitssymposium (USENIX Security 20), S. 1605-1622. 2020

Über Scalytics

Unser Hauptprodukt, Scalytics Connect, bietet intelligente Topics, kontinuierliches Lernen und KI-fähiges Messaging über das Model Context Protocol (MCP). Es verbindet verschiedene Datentypen und stellt sicher, dass Regeln eingehalten werden und die Privatsphäre geschützt wird, ohne dass die Pipelines, die Teams bereits nutzen, geändert werden müssen.

Mit Funktionen wie Autodiscovery und indexbasierter Suche bietet Scalytics Connect ein zukunftsweisendes, transparentes Framework, das schnelle Produktiteration, robuste Skalierung und erklärbare KI unterstützt. Durch die Kombination von Agenten, Datenflüssen und Geschäftsanforderungen hilft Scalytics Unternehmen, traditionelle Beschränkungen zu überwinden und die Möglichkeiten moderner KI voll auszuschöpfen.

Wenn Sie professionelle Unterstützung von unserem Team von branchenführenden Experten benötigen, können Sie sich jederzeit an uns über Slack oder E-Mail wenden.